Duomenų „skrapinimas" (Web Scraping) su AI: Everything You Need to Know in 2025

Duomenų rinkimas iš interneto svetainių pastaraisiais metais patyrė tikrą revoliuciją. Tradicinis duomenų „skrapinimas" (angl. web scraping) ilgą laiką reikalavo gilių programavimo įgūdžių ir techninių žinių, tačiau dirbtinis intelektas (AI) visiškai pakeitė taisykles. Šiandien AI transformavo šį procesą į prieinamesnį, efektyvesnį ir galingesnį įrankį, kuris tapo nepakeičiamu bet kuriai duomenimis grįstai organizacijai.

A

Duomenų „skrapinimas" su AI – tai ne tik kodo rašymas, bet ir natūralios kalbos nurodymų naudojimas informacijos gavimui, kas leidžia net ir neprogramuotojams išgauti vertingus duomenis iš įvairiausių interneto šaltinių.

Ši nauja technologijų banga pasižymi ypatingu greičiu, mažesniu barjerų skaičiumi ir galimybe veikti masteliu, kuris anksčiau buvo nepasiekiamas. Šiame straipsnyje išnagrinėsime, kaip AI keičia duomenų rinkimo procesus, kokios yra geriausios AI skrapinimo platformos 2025 metais, kaip pasirinkti tinkamiausią įrankį savo poreikiams ir pamatysime realius AI skrapinimo pritaikymo pavyzdžius.

Kaip AI transformuoja duomenų skrapinimą

Dirbtinio intelekto integravimas į duomenų rinkimo procesus iš esmės pakeitė ne tik pačią technologiją, bet ir darbų srautą. Dabar vietoj sudėtingų selektorių ir kodo rašymo galima tiesiog pateikti natūralios kalbos užklausas, o AI pats supras, kokius duomenis reikia išgauti ir kaip juos struktūrizuoti.

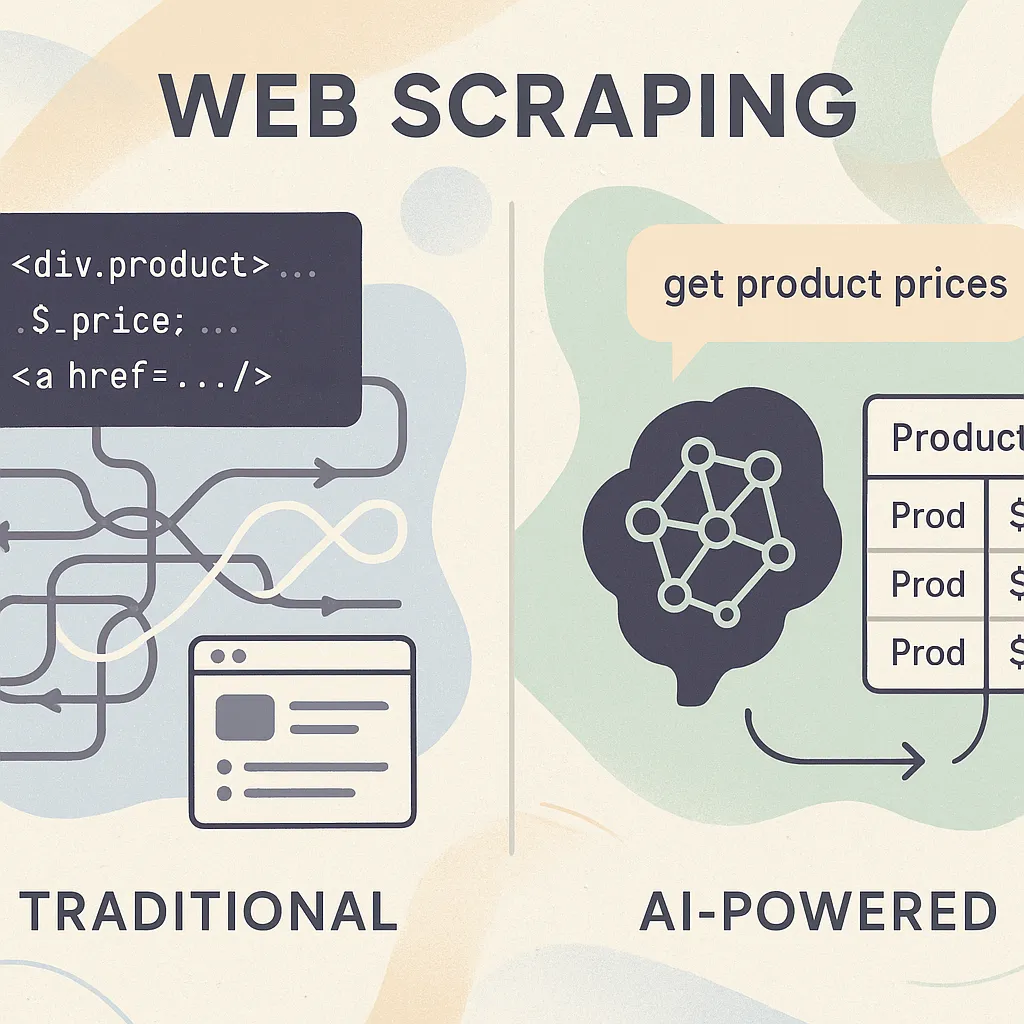

Tradicinio ir AI skrapinimo palyginimas

Tradicinis duomenų skrapinimas dažniausiai remiasi keliomis pagrindinėmis technologijomis – HTML analizavimu, CSS selektoriais ir XPath užklausomis. Programuotojai turi rankiniu būdu identifikuoti elementus, kuriuos nori išgauti, sukurti selektorius ir rašyti kodą, kuris galėtų navigacijos, puslapiavimo ir duomenų išgavimo procesus. Tačiau svetainėms keičiantis, šie skriptai dažnai nustoja veikti ir reikalauja nuolatinio atnaujinimo.

AI skrapinimas visiškai keičia šį procesą:

A

- Natūralios kalbos užklausos: vietoj techninių selektorių, naudotojai gali tiesiog pasakyti, ką nori išgauti (pvz., "surink visus produktų pavadinimus ir kainas").

- Automatinis schemos nustatymas: AI gali išanalizuoti svetainės struktūrą ir automatiškai nustatyti duomenų tipą bei hierarchiją.

- Adaptyvumas: kai svetainės keičiasi, AI gali prisitaikyti ir rasti naujus būdus išgauti tuos pačius duomenis.

- Apsauga nuo blokavimo: pažangūs algoritmai padeda išvengti aptikimo ir blokavimo mechanizmų.

- Duomenų formatavimas ir valymas: AI gali automatiškai formatuoti, valyti ir transformuoti gautus duomenis į norimą formatą.

Atlikus testavimą su Gumloop ir Firecrawl platformomis, tapo aišku, kad AI sprendimai išsprendžia tris pagrindines tradicinio skrapinimo problemas: selektorių sudėtingumą, puslapiavimą ir CAPTCHA atpažinimą. Pavyzdžiui, Firecrawl naudoja LLM (Large Language Models) modelius, kurie gali automatiškai naviguoti sudėtingose svetainėse ir išgauti struktūruotus duomenis be išankstinio kodo rašymo.

Šie privalumai itin naudingi tiek programuotojams, kurie gali efektyviau išnaudoti savo laiką, tiek neprogramuotojams, kurie dabar gali savarankiškai automatizuoti duomenų rinkimo procesus.

Geriausi AI duomenų skrapinimo įrankiai ir platformos (2025 apžvalga)

Šiuolaikinėje rinkoje galima rasti įvairių AI skrapinimo įrankių, pritaikytų skirtingoms naudotojų grupėms ir poreikiams.

A

Juos galima suskirstyti į tris pagrindines kategorijas.

Sprendimai be kodo arba su minimaliu kodavimu

Šie įrankiai skirti visiems naudotojams, nepriklausomai nuo jų techninių įgūdžių:

- Gumloop – intuityvus įrankis su tempk-ir-paleisk sąsaja, leidžiančia sukurti sudėtingus duomenų rinkimo darbo eigas. Išsiskiria galimybe integruotis su kitomis platformomis ir automatizuoti periodišką duomenų atnaujinimą.

- Browse AI – specialiai sukurtas stebėti svetainių pakeitimus. Puikiai tinka konkurentų kainų stebėsenai ir naujų produktų sekimui. Naudoja AI modelius, kurie gali išgauti duomenis iš dinamiškai besikeičiančių svetainių.

- Kadoa – specializuojasi e-komercijos platformose. Automatiškai aptinka produktų duomenis ir gali išgauti informaciją net iš sudėtingų produktų puslapių, įskaitant variantus ir specifikacijas.

- Thunderbit – pritaikytas rinkodaros specialistams ir pardavėjams. Pasižymi galimybe rinkti kontaktinę informaciją ir generuoti potencialių klientų sąrašus iš įvairių šaltinių.

- Octoparse – vienas iš seniausių, bet nuolat atsinaujinančių įrankių, dabar integravęs AI funkcijas. Siūlo platų šablonų pasirinkimą dažniausiai naudojamoms svetainėms.

Norintiems automatizuoti duomenų rinkimą be programavimo žinių, rekomenduojame išbandyti Gumloop arba Browse AI, kurie siūlo nemokamus planus pradžiai.

Atviro kodo ir į programuotojus orientuoti AI skrapinimo įrankiai

Šie sprendimai suteikia daugiau lankstumo ir kontrolės techninių žinių turintiems naudotojams:

- Firecrawl – atviro kodo sistema, leidžianti naudoti AI duomenų išgavimui per API. Pasižymi greičiu ir galimybe veikti tiek debesyje, tiek lokalioje aplinkoje.

- Parsera – integruoja LLM modelius su tradiciniais skrapinimo įrankiais, suteikdama programuotojams lankstumą pritaikyti sprendimus konkretiems poreikiams.

- Crawl4AI – specializuojasi didelio masto duomenų rinkimo projektuose ir siūlo pažangius proxy rotacijos mechanizmus.

- Scrapy-LLM – populiaraus Scrapy framework'o praplėtimas, integruojantis LLM funkcionalumą į esamus skriptus.

Šie įrankiai paprastai reikalauja daugiau techninio išmanymo, tačiau suteikia didesnį lankstumą ir mažesnes sąnaudas didelio masto projektams.

Pagrindinės funkcijos, kainodara ir apribojimai

Dauguma platformų naudoja kreditais grįstą kainodarą, kur apmokestinama pagal išanalizuotų puslapių skaičių. Verta atkreipti dėmesį, kad papildomos funkcijos, tokios kaip proxy rotacija ar anti-blokavimo technologijos, dažnai būna prieinamos tik aukštesnės klasės planuose.

Kaip pasirinkti tinkamą AI skrapinimo įrankį

Tinkamo įrankio pasirinkimas priklauso nuo keleto esminių faktorių, kuriuos būtina įvertinti prieš pradedant duomenų skrapinimo projektą.

Dažniausios panaudojimo sritys ir anti-blokavimo strategijos

Skirtingos industrijos naudoja duomenų skrapinimą skirtingais tikslais:

- Potencialių klientų generavimas – kontaktinės informacijos rinkimas iš profesinių tinklų ir įmonių svetainių.

- Kainų stebėsena – konkurentų kainų sekimas ir automatinis reagavimas į pakeitimus.

- Turinio agregavimas – naujienų, straipsnių ir kitų informacinių šaltinių rinkimas.

- Sentimento analizė – atsiliepimų ir socialinių tinklų komentarų rinkimas nuomonės tyrimams.

- Rinkos analizė – tendencijų ir naujų produktų stebėjimas.

Kiekvienai sričiai gali būti tinkamesni skirtingi įrankiai. Pavyzdžiui, Browse AI puikiai tinka kainų stebėsenai, o Thunderbit – potencialių klientų paieškai.

Anti-blokavimo strategijos tapo esminis skrapinimo elementas, kadangi dauguma populiarių svetainių aktyviai blokuoja automatinius įrankius. Modernūs AI skraperiai naudoja įvairias technologijas:

- Proxy rotacija – nuolatinis IP adresų keitimas užklausoms

- Žmogiško elgesio imitacija – atsitiktiniai laukimo intervalai, natūralus naršymas

- Headless naršyklės – visiškas naršyklės funkcionalumas be vartotojo sąsajos

- CAPTCHA sprendimas – automatinis arba per išorinių paslaugų teikėjus

Renkantis įrankį, verta įvertinti, kokios apsaugos priemonės dominančiose svetainėse yra naudojamos ir ar pasirinktas įrankis gali jas įveikti.

Atviro kodo ir proprietariniai AI skrapinimo įrankiai

Pasirinkimas tarp atviro kodo ir proprietarinių įrankių dažnai priklauso nuo jūsų techninių galimybių ir biudžeto:

- Privalumai: nemokami, labai pritaikomi, skaidrūs, bendruomenės palaikymas

- Trūkumai: reikalauja techninių žinių, papildomų išteklių diegimui ir priežiūrai

- Privalumai: paprastas naudojimas, profesionalus palaikymas, integruotos anti-blokavimo funkcijos

- Trūkumai: prenumeratos mokesčiai, mažesnis lankstumas, galimi naudojimo apribojimai

Mažoms įmonėms ir pradedantiesiems dažniausiai geriau rinktis proprietarinius, į naudotoją orientuotus sprendimus kaip Gumloop ar Browse AI, o didesnėms organizacijoms su IT komandomis – atviro kodo sprendimus, kurie gali būti pritaikyti specifiniams poreikiams.

Realūs AI duomenų skrapinimo pritaikymo pavyzdžiai

Duomenų automatizavimas su AI jau keičia kasdienę įmonių veiklą įvairiuose sektoriuose. Štai keli realūs pritaikymo pavyzdžiai, demonstruojantys šios technologijos vertę.

Konkurentų stebėsena e-komercijos sektoriuje

Vidutinio dydžio elektroninės prekybos įmonė naudoja Browse AI, kad automatiškai sektų konkurentų kainų pokyčius. Sistema stebi 15 skirtingų konkurentų svetaines, apimant daugiau nei 5000 produktų. Kai konkurentų kainos sumažėja daugiau nei 5%, sistema automatiškai siunčia įspėjimus rinkodaros komandai, kuri gali operatyviai reaguoti. Šis automatizuotas procesas leido įmonei sumažinti rankinį darbą 20 valandų per savaitę ir padidinti pelningumą 12%, kadangi kainos visada išlieka konkurencingos.

A

Rinkos tyrimai su Parsera ir Apify

Konsultacinė įmonė, dirbanti su nekilnojamojo turto sektoriumi, sukūrė automatizuotą duomenų rinkimo sistemą, naudojančią Parsera AI funkcionalumą kartu su Apify platformos masto galimybėmis. Ši sistema renka duomenis iš daugiau nei 50 nekilnojamojo turto portalų, įskaitant kainas, objektų charakteristikas ir rinkos tendencijas. Surinktų duomenų pagrindu sukurta analitinė platforma, kuri generuoja išsamias rinkos ataskaitas ir prognozes. Šis sprendimas leido sumažinti tyrimų kaštus 60% ir padidinti duomenų tikslumą, pašalinant žmogiškų klaidų galimybę.

Potencialių klientų paieška su Thunderbit

B2B programinės įrangos pardavimo komanda naudoja Thunderbit platformą potencialių klientų paieškai. Sistema automatiškai skanuoja įmonių svetaines, LinkedIn profilius ir profesines asociacijas, rinkdama kontaktinę informaciją, įmonių dydžio duomenis ir technologinių sprendimų naudojimo informaciją. Surinkti duomenys automatiškai integruojami į CRM sistemą ir sukuria prioritetizuotą potencialių klientų sąrašą pagal nustatytus kriterijus. Šis automatizuotas darbo srautas padidino pardavimo komandos produktyvumą 35% ir pagerino konversijos rodiklius 22%, kadangi kreipiamasi į tikslingiau atrinktus potencialius klientus.

Šie pavyzdžiai iliustruoja, kaip AI skrapinimo įrankiai gali būti pritaikyti įvairiems verslo poreikiams – nuo konkurencinio pranašumo kūrimo iki sprendimų priėmimo tobulinimo. Svarbiausia, kad šios technologijos tampa vis labiau prieinamos įvairaus dydžio organizacijoms, ne tik didžiosioms korporacijoms su dideliais IT biudžetais.

Išvados

AI duomenų skrapinimo technologijos 2025 metais jau nėra vien tik techninių specialistų įrankis – jos tapo prieinamos ir naudingi visiems, kas nori išnaudoti internetinių duomenų galią savo veikloje. Transformacija nuo sudėtingų programavimo reikalavimų iki natūralios kalbos užklausų atvėrė šią technologiją naujoms naudotojų grupėms ir pritaikymo galimybėms.

Renkantis tinkamiausią įrankį, verta apgalvoti savo techninius gebėjimus, projekto mastą ir biudžetą. Pradedantiesiems rekomenduojama išbandyti nemokamus planus, kuriuos siūlo Gumloop ar Browse AI platformos, kad susipažintų su AI skrapinimo galimybėmis be pradinio investicijų. Pažengusiems naudotojams ir organizacijoms su specifiniais poreikiais verta apsvarstyti lankstesnius, į programuotojus orientuotus sprendimus kaip Firecrawl ar Parsera.

Nepriklausomai nuo pasirinkto sprendimo, AI duomenų skrapinimas reikšmingai keičia verslo analitikos, rinkos tyrimų ir duomenimis grįstų sprendimų priėmimo procesus, leisdamas organizacijoms efektyviau rinkti ir panaudoti vertingus internetinius duomenis. Technologijoms toliau vystantis, galime tikėtis dar labiau išmanių ir prieinamų sprendimų, kurie dar labiau demokratizuos prieigą prie vertingų duomenų.

Dažniausiai užduodami klausimai (DUK)

1. Kas yra AI duomenų skrapinimas ir kuo jis skiriasi nuo tradicinio?

AI duomenų skrapinimas naudoja mašininio mokymosi modelius (pvz., LLM) automatizuoti duomenų išgavimą, sumažinant rankinio kodavimo ir selektorių kūrimo poreikį. Skirtingai nuo tradicinių skriptų, AI skraperiai gali atpažinti duomenų struktūras, prisitaikyti prie besikeičiančių tinklalapių ir dažnai palaiko natūralios kalbos užklausas.

2. Ar AI skrapinimo įrankiai tinkami neprogramuotojams?

Taip, daugelis šiuolaikinių platformų yra sukurtos būtent naudotojams be programavimo patirties. Jos siūlo tempk-ir-paleisk darbo aplinkas bei paprastas užklausas sudėtingoms skrapinimo užduotims automatizuoti.

3. Kokie skirtumai tarp atviro kodo ir proprietarinių AI skrapinimo įrankių?

Atviro kodo įrankiai paprastai yra labiau pritaikomi ir palankesni programuotojams, tačiau gali reikalauti techninių žinių ir nuolatinio diegimo. Proprietariniai sprendimai siūlo supaprastintą naudotojo patirtį, palaikymą ir patikimą integraciją, tačiau didesnėse apimtyse gali kainuoti brangiau.

4. Kaip veikia AI skrapinimo įrankių kainodara?

Dauguma platformų naudoja kreditais grįstą kainodarą, apmokestindamos už kiekvieną išanalizuotą puslapį ar užduotį. Kai kurios siūlo nemokamus planus, tačiau plečiant veiklą ar pridedant papildomų funkcijų (pvz., proxy rotaciją ar apsaugą nuo blokavimo) paprastai reikia mokamo plano.

5. Kokius teisinius ar etinius aspektus reikėtų apsvarstyti naudojant AI skrapinimo įrankius?

Visuomet rekomenduojama peržiūrėti svetainės naudojimo sąlygas prieš pradedant skrapinimą ir užtikrinti, kad laikomasi vietinių įstatymų. Venkite rinkti asmeninius ar jautrius duomenis be sutikimo ir gerbkite robots.txt taisykles, kur jos taikomos. Nors AI sumažina technines kliūtis, atsakomybė už etišką naudojimą išlieka naudotojo pusėje.